DeepSeek AI开发的费用为16亿美元,揭穿了负担能力神话

DeepSeek的新聊天机器人以一个令人着迷的诺言介绍了自己:“嗨,我被创建了,您可以问任何东西,并得到一个甚至可能让您感到惊讶的答案。”该声明囊括了DeepSeek目标在竞争激烈的AI市场中的目标,最近由于DeepSeek的影响,NVIDIA最大的股票价格下跌之一。

图片:ensigame.com

图片:ensigame.com

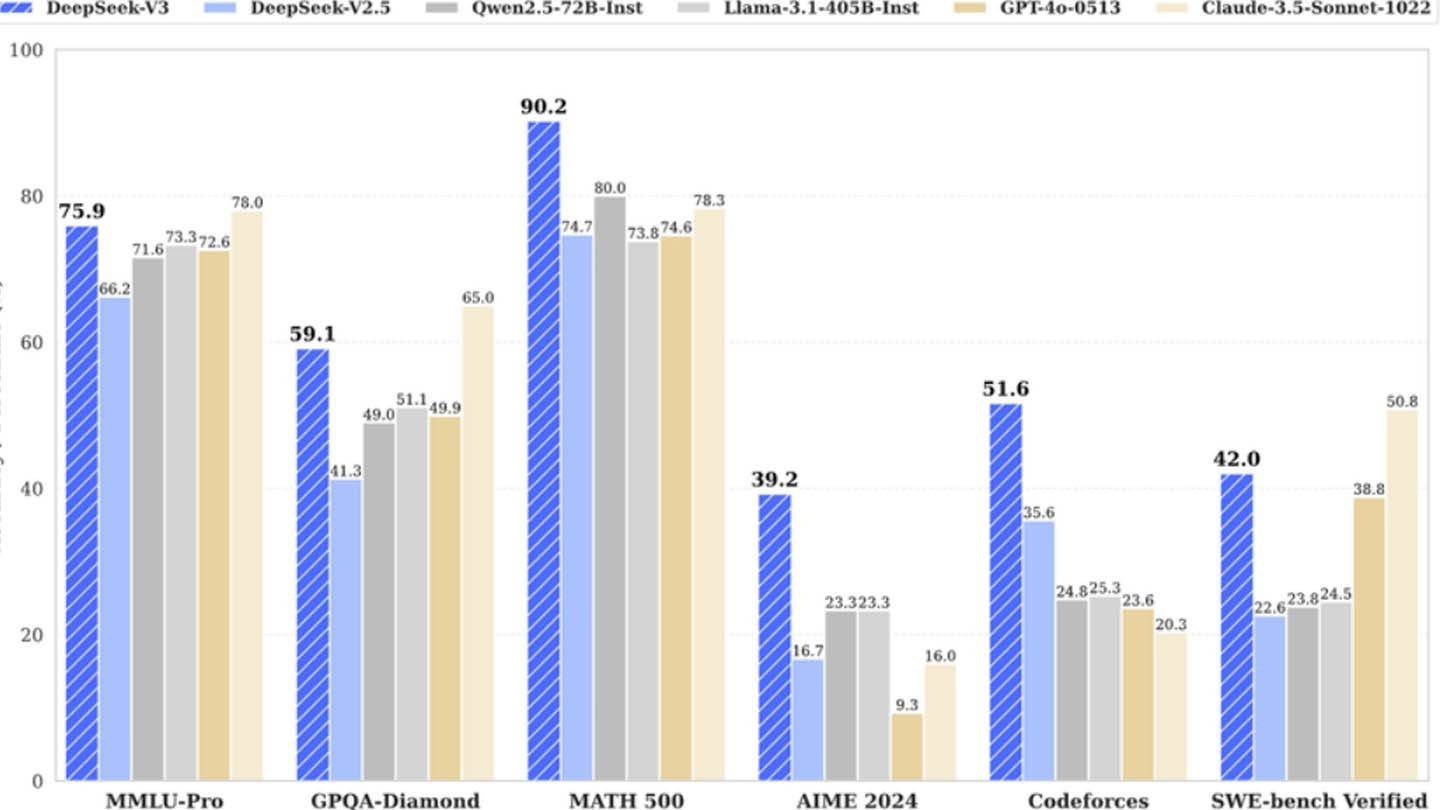

DeepSeek的AI模型由于其创新的建筑和培训方法而脱颖而出。以下是区分它的关键技术:

多语预测(MTP) :与一次预测一个单词的传统模型不同,DeepSeek的MTP通过分析句子的不同部分同时预测了多个单词。这种方法不仅提高了准确性,还提高了模型的效率。

专家的混合物(MOE) :DeepSeek V3采用MOE架构,利用256个神经网络,每个令牌处理任务都激活了8个。这种方法加速了AI训练并大大提高了性能。

多头潜在注意力(MLA) :MLA通过反复从文本片段中提取关键细节来关注句子的最重要部分。这减少了缺少关键信息的机会,从而使AI有效地捕获了重要的细微差别。

尽管声称已经开发了一种竞争性的AI模型,该模型仅使用2048个图形处理器来培训DeepSeek V3的预算最低,但进一步的调查显示了一个更复杂的情况。

图片:ensigame.com

图片:ensigame.com

半分析的分析师发现,DeepSeek经营着大量的计算基础设施,包括约50,000个NVIDIA HOPPER GPU。其中包括10,000个H800单元,另外10,000 h100和额外的H20 GPU,分布在多个数据中心,以进行AI培训,研究和财务建模。对服务器的总投资约为16亿美元,运营费用估计为9.44亿美元。

DeepSeek是中国对冲基金高飞行员的子公司,该基金在2023年脱颖而出,专注于AI技术。与许多依靠云提供商的初创公司不同,DeepSeek拥有其数据中心,使其完全控制AI模型优化并实现快速创新。该公司是自筹资金的,可以提高其灵活性和决策速度。

图片:ensigame.com

图片:ensigame.com

DeepSeek还吸引了顶尖人才,一些研究人员每年收入超过130万美元,主要来自中国领先的大学。在考虑更广泛的环境时,该公司对仅600万美元培训其最新模式的培训似乎是不现实的。该图仅说明在预培训期间使用GPU,并排除了研究费用,改进,数据处理和整体基础设施成本。

自成立以来,DeepSeek已在AI开发方面投资了超过5亿美元。它的紧凑结构允许积极有效地实施AI创新,这与更大,更官僚的公司不同。

图片:ensigame.com

图片:ensigame.com

DeepSeek的旅程表明,一家资金充足的独立AI公司确实可以与行业巨头竞争。但是,专家指出,其成功是由于大量投资,技术突破和强大的团队,而不是为AI开发的“革命性预算”。尽管如此,DeepSeek的成本仍大大低于其竞争对手。例如,尽管DeepSeek在R1上花费了500万美元,但Chatgpt4o的培训耗资1亿美元。

但是,它仍然比竞争对手便宜。